Сегодня камеры видеонаблюдения превратились из пассивных датчиков в активный инструмент для бизнеса. Это стало возможным благодаря видеоаналитике — технологии на базе искусственного интеллекта, которая анализирует видеопоток в реальном времени, извлекает из него важные данные и помогает принимать решения.

Но внедрение такой системы — это не просто покупка камеры с нужными характеристиками. Зачастую это инженерная задача, требующая кастомного подхода.

Вместо того чтобы перечислять стандартные функции вроде распознавания лиц, мы, как разработчики, хотим показать, с какими реальными вызовами сталкивается бизнес и как они решаются с помощью видеоаналитики.

«Каждой задаче по камере»

Камера — это первичный и самый важный датчик в системе видеоаналитики. Если датчик поставляет некачественные данные (смазанное, засвеченное, искаженное изображение), никакая, даже самая умная, нейросеть не сможет их корректно обработать.

Пример из практики:

Крупное промышленное предприятие столкнулось с частыми разрывами конвейерной ленты после перехода на более дешевые китайские аналоги. Каждый разрыв означал остановку всей производственной линии и колоссальные убытки. Стандартными средствами отследить износ было невозможно.

Задача: предсказывать критический износ ленты, чтобы проводить замену превентивно.

Решением стала установка системы видеоаналитики. Но сразу же возникли нетривиальные инженерные проблемы:

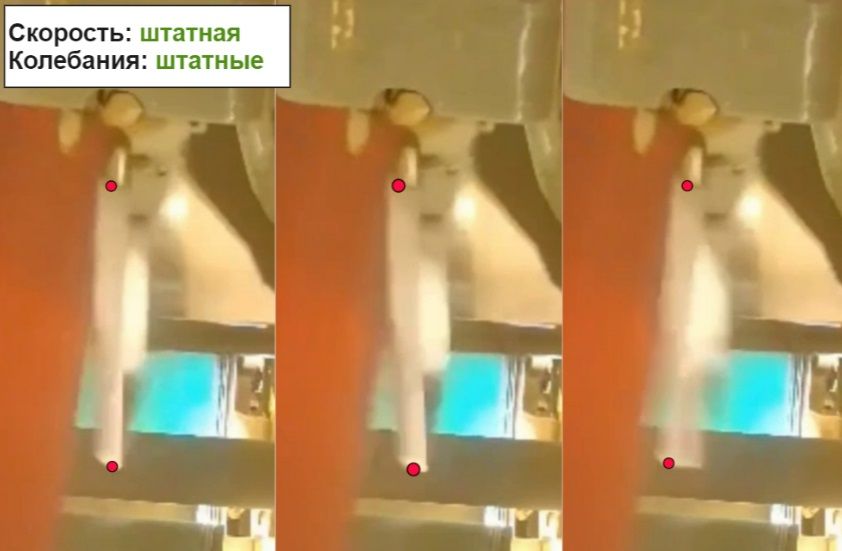

- Вибрация: станок сильно вибрировал, из-за чего изображение с камеры было постоянно смазанным и непригодным для анализа.

- Температура: высокая температура в цеху быстро выводила электронику из строя.

Просто купить и повесить камеру было нельзя. Инженерам пришлось разработать специальную виброгасящую конструкцию и поместить камеру в промышленный термокожух с активной системой охлаждения. Только после решения этих аппаратных задач были получены стабильные и четкие данные, на которых нейросеть могла научиться находить целевые события, предсказывая будущий разрыв.

Этот кейс наглядно демонстрирует: выбор и установка камеры под конкретную задачу — это полноценный R&D-проект, иногда требующий экспертизы в оптике, механике и электронике, а не только в программировании.

Хотите больше реальных бизнес-кейсов и полезной информации из мира данных? Подписывайтесь на наш Telegram-канал, где мы делимся экспертизой и новостями компании.

Задача измерения расстояния

Одна из самых сложных, но востребованных задач в промышленной видеоаналитике — контроль опасных зон. Как системе понять, что работник подошел к работающему механизму ближе чем на 5 метров? Ведь на плоском изображении эти 5 метров будут выглядеть по-разному в зависимости от ракурса, высоты установки камеры и оптики.

Метод "виртуальной линейки"

Еще недавно мы решали эту задачу через привязку к статичным объектам.

- Принцип: для каждого конкретного ракурса мы проводили калибровку. Инженер измерял реальное расстояние от камеры до нескольких точек в кадре (например, до угла станка или колонны). Эти данные заносились в систему.

- Как это работало: нейросеть, зная эти опорные точки и их реальные координаты, могла построить "виртуальную линейку" и с приемлемой точностью рассчитать расстояние до движущихся объектов (людей, техники) в этой же плоскости.

- Недостатки: метод был жестко привязан к одному ракурсу. Любое смещение камеры требовало полной перекалибровки. К тому же он плохо работал в больших открытых пространствах без четких ориентиров. Сбор данных был трудоемким: для каждого ракурса требовались тысячи изображений при разном освещении.

Стереозрение и гибридные модели

Технологии не стоят на месте. Сегодня для определения расстояния используются более совершенные методы, которые позволяют отойти от жесткой покамерной калибровки.

- Стереоскопическое зрение: по аналогии с человеческими глазами, используются две синхронизированные камеры, разнесенные на известное расстояние. Система анализирует параллакс — небольшое смещение объектов на изображениях с левой и правой камер. На основе этого смещения нейросеть строит точную карту глубины (depth map) для всей сцены и может измерять расстояние до любого объекта в кадре с высокой точностью. Этот метод гораздо более гибкий и не требует привязки к статичным ориентирам.

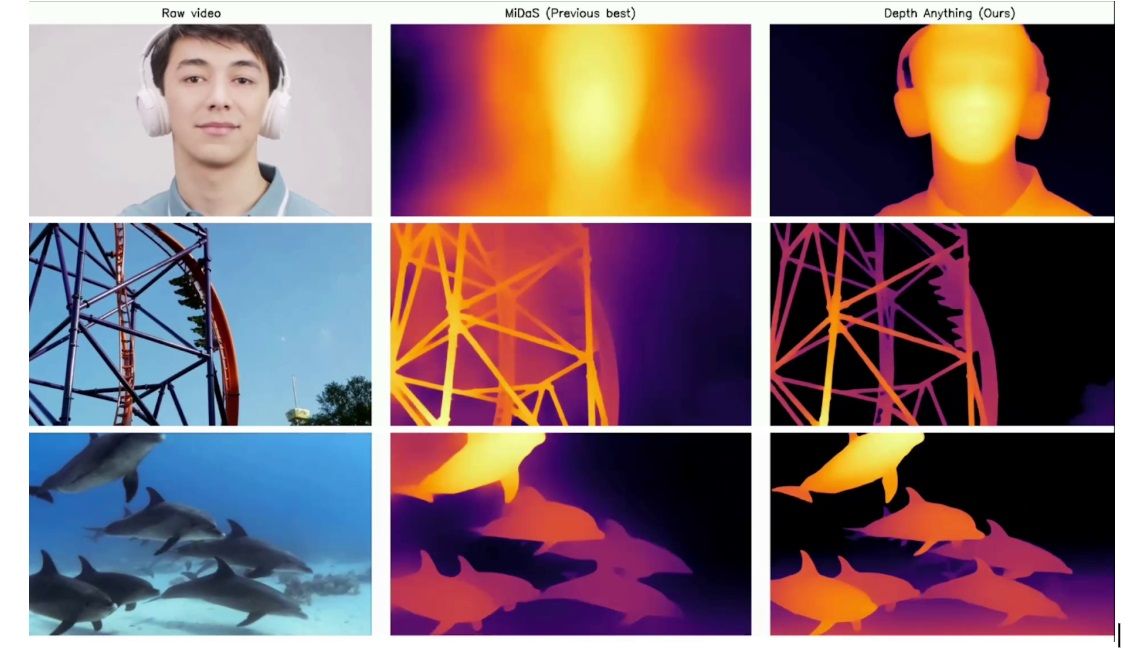

- Эволюция Monocular Depth Estimation: модели, оценивающие глубину по одному изображению (монокулярному), такие как Depth Anything и их более современные аналоги, стали значительно точнее. Главный прорыв — появление гибридных моделей. Они сочетают в себе мощь предварительно обученных на огромных датасетах сетей с возможностью быстрого дообучения (fine-tuning) на специфических данных заказчика. Это позволяет адаптировать модель под уникальные условия объекта (например, туман, пар, специфическое освещение в цеху) без дорогостоящего и длительного полного переобучения.

- LiDAR и синтез данных: в особо критичных задачах камеры все чаще дополняются LiDAR-сенсорами. LiDAR с помощью лазерных лучей строит сверхточное 3D-облако точек окружающего пространства. Эти данные используются не только для прямого измерения, но и для генерации синтетических данных для обучения нейросетей. Можно создать точную цифровую копию цеха, поместить в нее виртуальных людей и технику, и на этих данных обучить нейросеть работать в тысячах различных сценариев, которые сложно или опасно воссоздавать в реальности.

Эти новые подходы позволяют решать задачу измерения расстояния гораздо более универсально и точно, снижая зависимость от конкретного ракурса камеры.

Как правильно выбрать систему видеоаналитики?

Как видно из примеров, не существует "универсальной" камеры для видеоаналитики.

Правильный выбор — это всегда баланс между задачей, условиями и бюджетом.

Ключевой вывод, который мы доносим до наших клиентов: начинать нужно не с вопроса «Какую камеру купить?», а с детального анализа задачи и среды.

- Что мы хотим измерить или обнаружить? (Размер дефекта, скорость объекта, расстояние до зоны).

- В каких условиях будет работать камера? (Вибрация, температура, влажность, пыль, уровень освещенности).

- Какая точность нам необходима? (Погрешность в сантиметрах или метрах).

Ответы на эти вопросы определят, потребуется ли вам стандартное решение, система из двух камер (стереопара) или даже комбинация с LiDAR. Внедрение видеоаналитики — это в первую очередь инжиниринг, и только во вторую — программирование.

Границы применимости видеоаналитики

Видеоаналитика опирается на видеоданные как на измерительный сигнал, а значит наследует все ограничения оптических систем. В условиях, где визуальная информация нестабильна или искажена, качество модели ограничивается не архитектурой нейросети, а физикой формирования изображения.

На практике это проявляется в средах с интенсивным парообразованием, дымом, аэрозолями, высокой запылённостью, а также при наличии выраженных бликов и отражающих поверхностей. В таких сценариях деградация сигнала происходит быстрее, чем возможна компенсация алгоритмическими методами — включая постобработку, temporal filtering и дообучение моделей.

Существуют и классы задач, где camera-only подход имеет принципиальные ограничения. Это задачи с требованиями к высокой метрологической точности, а также случаи работы с объектами без устойчивых визуальных признаков. В подобных сценариях камеры либо используются в составе мультисенсорных конфигураций, либо уступают альтернативным датчикам.

Отдельного внимания требует переносимость решений. Модели, обученные в одном пространственном и световом контексте, чувствительны к изменениям геометрии сцены, фона и распределения освещения. Даже при сохранении формального класса задачи такие изменения приводят к снижению точности и требуют адаптации.

Выбор видеоаналитики оправдан только в тех случаях, где визуальный сигнал является достаточным, устойчивым и экономически рациональным источником данных.

Эксплуатация и совокупная стоимость владения (TCO)

Экономика видеоаналитических решений определяется не только затратами на внедрение, но и стоимостью эксплуатации на протяжении всего жизненного цикла системы. Именно этот горизонт чаще всего становится определяющим для реального ROI.

Оптические и аппаратные компоненты подвержены постепенной деградации: загрязнение оптики, смещение креплений, износ виброразвязки, изменение световой сцены по мере эксплуатации объекта. Эти факторы напрямую влияют на распределение данных и, как следствие, на устойчивость моделей.

В эксплуатационные затраты входят:

- регулярные процедуры калибровки,

- обслуживание защитных кожухов и систем охлаждения,

- замена аппаратных компонентов,

- поддержка вычислительной инфраструктуры и каналов передачи данных.

Отдельный слой TCO связан с поддержкой моделей. По мере изменения сцены, оборудования и технологических процессов происходит data drift, требующий повторной адаптации моделей. Это не исключение, а нормальное состояние production-систем машинного зрения.

Поэтому зрелые проекты оценивают совокупную стоимость владения на горизонте нескольких лет, а не в рамках пилотного бюджета или первой очереди внедрения.

У вас есть задача, которую надо решить с помощью видеоаналитики?

Если вы рассматриваете видеоаналитику под конкретную задачу — имеет смысл начать с обсуждения условий, ограничений и альтернатив. На практике именно этот этап определяет, станет ли система рабочим инструментом или дорогим экспериментом.

Оставить заявку в форме ниже | Читать наши кейсы | Написать нам в ТГ